[Pytorch] Conv1D + LSTM 모델 Pytorch 구현

·

🐍 Python/Deep Learning

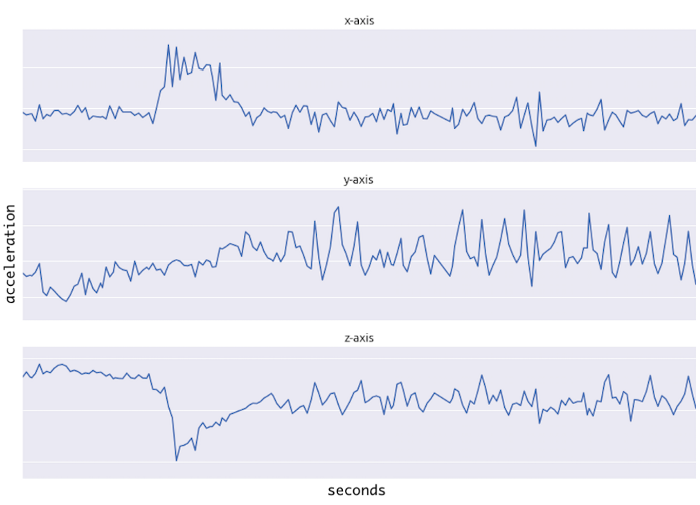

그림 참고 1: Early Warning Model of Wind Turbine Front Bearing Based on Conv1D and LSTM | IEEE Conference Publication | IEEE Xplore 그림 참고 2: Understanding 1D and 3D Convolution Neural Network | Keras | by Shiva Verma | Towards Data Science 1. 데이터셋 가정 Batch size : 100000 Sequence : 10 Feature : 3 (x-axis, y-axis, z-axis) Dataset shape : (100000, 10, 3) = (Batch size, Sequence, Feature) = (B, S, F) 2...