안녕하세요.

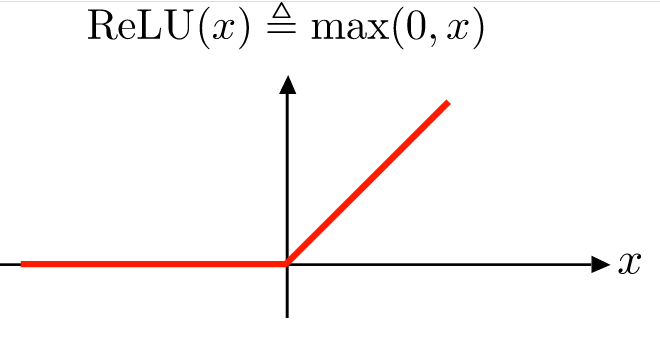

오늘은 딥러닝에서 가장 많이 사용되는 ReLU를 통해 비선형함수와 선형함수의 차이점을 알아보겠습니다.

머신러닝에서 선형함수를 통해 회귀문제를 해결할 수 있게 되었고, 더 복잡한 문제를 풀기 위해 비선형 함수 Sigmoid, Tanh, ReLU를 나오기 시작합니다.

현재까지 복잡한 문제를 딥러닝 분야에서 ReLU를 사용하는 것은 당연시 되고 있습니다.

바로, 본론으로 들어가겠습니다.

TesorFlow, Keras, Pytorch를 통해 ReLU를 사용하는 것은 굉장히 간단합니다.

신호 및 시스템의 개념적 이야기로 가보겠습니다.

ReLU는 왜 비선형 함수일까요?

선형 시스템과 비선형 시스템의 차이

선형성을 가지고 있으면 선형 시스템이고, 그 외는 비선형 시스템입니다.

선형성을 가지는 조건은 무엇일까요?

세 가지의 조건을 충족하면 선형성을 가진다고 이야기할 수 있습니다. 그 외에는 비선형 시스템으로 분류할 수 있습니다.

1. 선형적인 그래프

x = 0 에서 꺽이는 구간을 제외하고 전 구간이 선형성을 가지지만, (x =0) 부분 때문에 선형성을 가진다고 할 수 없습니다.

부끄럽지만, 저는 꺾이는 부분을 제외한 전 구간이 부분 선형형태를 띄우니 선형 함수가 맞지 않나라는 생각을 해 공부를 해서 찾아보았습니다.

2. 동차성 ( f(ax) = a * f(x) )

ReLU를 간단히 설명하면, x가 0보다 작으면 f(x) = 0, x가 0보다 크면 f(x) = x 입니다. 이를 f(x) = max(0, x)라 표현하겠습니다.

① a = 3으로 가정하면,

f(3x) = 3x

3 * f(x) = 3x

f(3x) = 3 * f(x) = 3x

② a = -3 으로 가정하면

f(-3x) = -3x

-3 * f(x) = -3x

f(-3x) = -3 * f(x) = -3x

ReLU는 동차성이 성립함을 알 수 있습니다.

3. 가산성 ( f(x1 + x2) = f(x1) + f(x2) )

x1 = -1, x2 = 2 라고 가정하면,

f(-1+2) = 1

f(-1) = 0,

f(2) =2

f(-1) + f(2) = 2

f(-1+2) != f(-1) + f(2)

ReLU는 가산성이 성립하지 않음을 알 수 있습니다.

ReLU는 동차성은 성립하지만, 가산성이 성립하지 않아 선형성을 가지지 않으므로 비선형 함수임을 알 수 있었습니다.